Pronti alla sfida della Exascale Science?

| Federica Tanlongo | Networking

I big data sono già qui e stanno rivoluzionando i modelli per elaborarli e conservarli. Ecco come le reti devono cambiare per supportare questo cambiamento

La rete è strumento fondamentale per la ricerca scientifica ed è importante poterne programmare l’evoluzione, anche in base a come cambiano le esigenze degli utenti, i modelli di collaborazione e di condivisione ed elaborazione dei dati. Con la guida di Tommaso Boccali, supervisore del progetto CNAF reloaded, che prevede l’integrazione delle risorse INFN al CNAF presso il Tecnopolo di Bologna, vediamo cosa sta succedendo in alcuni grandi esperimenti scientifici e come influirà sullo sviluppo delle reti per la ricerca.

Il calcolo nell’ambito della fisica sperimentale rappresenta una specie di archetipo di questi super-esperimenti da 1 Exabyte o più: oggi si tratta certo di un’eccezione, ma molte attività scientifiche data-intensive stanno andando in quella direzione ed è quindi istruttivo guardare a chi è partito per primo per progettare il futuro.

Il vero risultato degli esperimenti è proprio questa enorme massa di dati, spesso generati da eventi irripetibili

Dott. Boccali, può spiegarci qual è la particolarità dei vostri modelli di calcolo?

Schematizzando, possiamo dire che alla base dei modelli dedicati alla fisica sperimentale abbiamo delle infrastrutture scientifiche che generano dati con un ritmo eccezionalmente elevato e che vanno poi immagazzinati ed elaborati. Il vero risultato degli esperimenti è proprio questa enorme massa di dati, spesso generati da eventi irripetibili (pensiamo ad esempio all’osservazione di una supernova). Al centro del nostro modello vi è quindi la fondamentale esigenza di poterli trasferire in luoghi dove tenerli al sicuro ma, siccome crescono costantemente a ritmo così sostenuto, anche quella di ottimizzarne la fruibilità, ad esempio riducendo il numero di copie che è necessario conservare di un singolo dataset.

In altri campi, come le simulazioni, abbiamo necessità di elevate capacità di calcolo a fronte di un input/output relativamente trascurabile, ma nel nostro caso questo non basta: occorre in primo luogo una grande capacità di accesso.

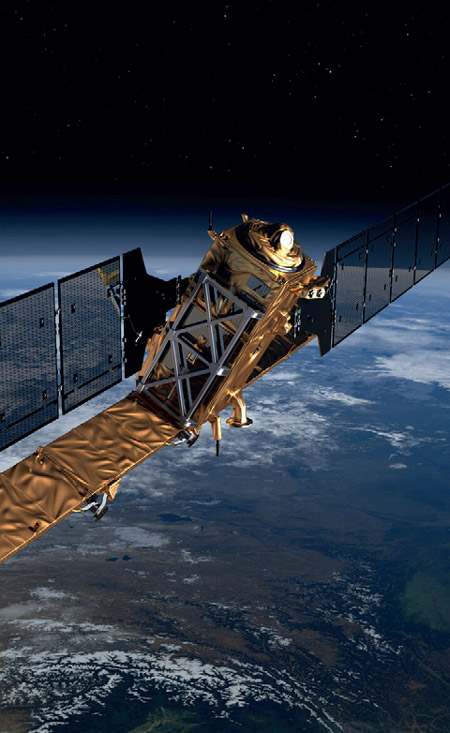

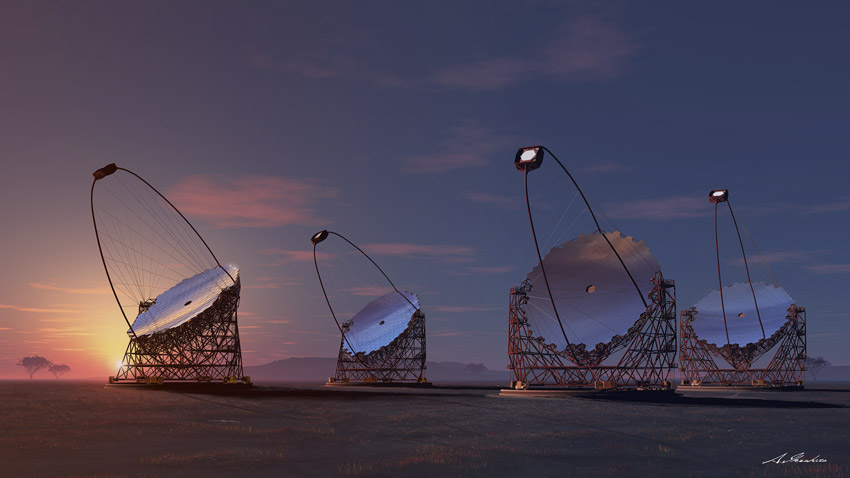

L’Exabyte era fino a pochi anni fa una grandezza considerata assolutamente inarrivabile, una sorta di “hic sunt leones” sulle carte delle infrastrutture di calcolo, e invece già nel 2020 LHC nel suo complesso lo ha superato; altre grandi collaborazioni come CTA, SKA, DUNE o Copernicus mirror vanno nella medesima direzione e raggiungeranno volumi simili entro questo decennio.

Per analizzare simili quantità di dati sono necessarie centinaia di migliaia di CPU core, che genereranno a loro volta nuovi dati. Questo andamento è in costante crescita: ad esempio, con i prossimi upgrade all’acceleratore LHC e ai suoi esperimenti, sul piano puramente teorico le richieste potrebbero crescere anche fino a 100 volte se non si trovano nuove soluzioni di gestione.

Come pensate di far fronte a questa crescita così sostenuta?

Ovviamente a livello pratico, ma soprattutto economico, centuplicare le risorse è impensabile, soprattutto se pensiamo a infrastrutture di calcolo proprietarie. Per questo una parte non secondaria dell’attività dei grandi esperimenti dal punto di vista dell’elaborazione dati è stata quella di cercare di ridurre queste esigenze: a LHC questo è in atto già da almeno 5 anni. Questo lavoro, però, servirà a rallentare la crescita della domanda di risorse ma non ad arrestarla. Si impone la necessità di cambiare prospettiva e passare dal tradizionale modello dei centri di calcolo dedicati a singoli esperimenti a un modello per così dire opportunistico, che permetta di utilizzare più o meno tutto quello che è disponibile sul mercato, anche in base alla disponibilità del momento e alla convenienza (non solo) economica.

In questo nuovo modello non c’è spazio per scelte tecnologiche esclusive in favore di un certo tipo di calcolo (ad esempio l’HPC rispetto all’HTC) e men che mai di singole architetture o tipi di processore. Al contrario è importante essere agnostici, in modo da non perdere delle possibilità: ad esempio poter usufruire di grant temporanei sulle risorse di un supercomputer o di un’offerta vantaggiosa da parte di un fornitore di cloud pubblico, se se ne presenta l’occasione.

Cosa significa tutto questo dal punto di vista del modello di calcolo?

La prima cosa che salta agli occhi è che i dati si spostano al centro del modello, mentre le risorse di calcolo che utilizziamo variano nel tempo e sono distribuite in diversi data centre o anche aree geografiche. In questo scenario, la località della elaborazione, o anche l’idea di mantenere i nostri dati vicini al centro di calcolo diventa meno praticabile e, in ogni caso, non rappresenta più una priorità. Infatti le elevate capacità disponibili sulle reti della ricerca abilitano già oggi il remote processing.

È fondamentale una rete ad alte prestazioni con capacità almeno al Terabit, che permetta di interconnettere i diversi elementi

Meglio quindi puntare ad avere uno o più siti ad alta affidabilità e sotto il controllo delle comunità di ricerca dove immagazzinare i nostri dati sia per l’elaborazione che per la conservazione a lungo termine, e utilizzare un modello di calcolo in cui i dati vengono acceduti là dove si trovano da processori anche remoti. Questo è in estrema semplificazione il modello del data lake, verso il quale si sta orientando un po’ tutta la fisica sperimentale, ma anche molte altre discipline. Ad esempio, in Europa c’è grande fermento in previsione della realizzazione di un data lake della ricerca medica. Oggi la quantità di dati biomedici a disposizione dei ricercatori non è ancora al livello di quella prodotta da discipline come la fisica, ma con l’accelerazione della evidence-based medicine e della medicina personalizzata questo settore si candida ad essere un altro serbatoio di progetti di ricerca all’Exabyte nel prossimo futuro.

Il modello va dunque verso un disaccoppiamento parziale o totale tra storage e calcolo: da un lato, una rete di infrastrutture di data storage ad alta capacità, affidabili e interconnesse, in cui i dati siano in sicurezza, protetti sia dal rischio di perdita attraverso opportuni meccanismi di ridondanza sia, se necessario, da quello di accessi non autorizzati - non molto importante per noi fisici, ma fondamentale per altre discipline come appunto la ricerca medica. E da dove possano essere “ripescati” in modo veloce e sicuro per poter essere nuovamente elaborati.

Dall’altro, tutto l’arsenale del calcolo scientifico e non solo: risorse CPU potenzialmente a vita media anche breve e non necessariamente vicine ai siti di storage, connessioni ai centri HPC e anche a cloud pubbliche e private. Tutto questo in uno scenario dove il calcolo scientifico diventa in qualche modo commodity e centri di calcolo multidominio più grandi e affidabili vanno a rimpiazzare il tradizionale modello dei centri posseduti e dedicati ai singoli esperimenti e organizzati in maniera gerarchica (tipo data grid). Nel mezzo, a far da collante, diventa ancor più vitale il ruolo della rete.

Cosa vi aspettate dalla rete della ricerca per supportare questo modello?

Il primo e imprescindibile requisito è la capacità: perché il modello che ho appena descritto funzioni, è fondamentale una rete ad alte prestazioni con capacità almeno al Terabit, che permetta di interconnettere i diversi elementi in modo affidabile e quanto più possibile trasparente.

Mentre il calcolo di per sé non ha grandissime implicazioni dal punto di vista della rete, salvo ovviamente quella di garantire una buona infrastruttura di comunicazione per i grandi centri di calcolo, l’accesso ai dati può averne di rilevanti. Questo avviene sia perché questa ampia capacità d’accesso è spesso richiesta in luoghi non necessariamente già ricchi di infrastrutture o addirittura remoti, come nel caso di molte infrastrutture di ricerca che generano dati, come acceleratori, rivelatori, antenne, telescopi; sia perché i siti dove trasferiamo, conserviamo e accediamo questi dati possono essere distribuiti, per ragioni tecniche ma anche di opportunità politica.

Con un accesso ad alta capacità, la distanza tra i dati e le risorse di calcolo diventa un fattore trascurabile e l’elaborazione può avvenire sia collegandosi al nodo più vicino del data lake e elaborando i dati in streaming, sia utilizzando meccanismi di caching. La capacità da sola, però, potrebbe non essere sufficiente. Infatti, come abbiamo visto, mentre in questo modello il data lake resta sostanzialmente dov’è, le risorse di calcolo cambiano nel tempo e questo può avvenire, in linea di principio, anche molto velocemente: la nostra rete deve essere flessibile e in grado di adattarsi dinamicamente, permettendo ad esempio di accendere percorsi di rete on-demand verso centri di ricerca, HPC, e anche cloud commerciali in tempi brevi.

L’ultimo aspetto che vorrei sottolineare è la dimensione sempre più globale in cui si articolano le infrastrutture di ricerca ormai in ogni disciplina. LHC e le altre grandi collaborazioni di fisica sperimentale sono forse gli esempi più spettacolari, ma non certo gli unici. Il modello che ho descritto non si declinerà solo su scala nazionale o europea: già oggi raccogliamo dati da infrastrutture uniche che possono trovarsi in altri continenti e avremo sempre di più nodi nazionali o regionali nei vari paesi; per l’elaborazione, sceglieremo le nostre risorse di calcolo su scala globale. Perché tutto questo funzioni quindi, è fondamentale che si possano stabilire reti multi-Terabit anche su scala extracontinentale, grazie alle collaborazioni tra reti della ricerca.